AI时代的存力腾飞

在数字经济大潮下,数据已经成为新型的生产资料。

目前数据中心有三大力量:计算的力量——算力、存储的力量——存力、运输的力量——运力,即网络的力量。

算力产业链正在火热发展的同时,存力的需求也大幅度提升。2023年上半年,我国存力规模增长了23%,达到了1080EB。

为何存力越来越受到重视?因为不论大模型演进还是算力中心发展,都离不开海量的数据基础,和数据息息相关的存储。

中国工程院院士倪光南曾指出:“各地都在建AI算力中心,往往大家关心的就是每秒多少次的运算,这是算力,这显然很重要。但是AI计算从科学的角度来看应该用广义的算力来表示,存力、算力和运力三者合起来构成广义算力。”

01

存力的定义

随着智能世界的到来,数据量正在以惊人的速度增长,预计到2030年,全球数据将进入YB时代。

有数据的地方就需要数据存储,如何将数据进行妥善、安全地存储,就显得尤为重要,有赖于数据存储的综合能力,即数据存力。

计算存储能力的容量,采用单位GDP存储容量来确保不同国家的可比性,即用数据存储空间容量除以GDP规模。每一万美元GDP对应的存力容量越高,表明该国的数据存力容量水平越高,该国数字经济在GDP中的渗透程度越高,能更好支撑经济社会高质量发展。

测算结果显示,新加坡、捷克、美国等发达国家的单位GDP存储容量较高,每一万美元的GDP对应的存储容量分别达46.7GB、33.4GB、33.3GB,存储在经济发展中的支撑能力较为明显。南非、俄罗斯、中国等经济体量较大的发展中国家处于中间水平,每一万美元GDP对应的存储容量在23GB和31GB之间。

通过计算一国数据存储容量除以一国数据总产量可以反映当年一个国家或地区所生产的所有数据中,有多大占比可以被存储,以反映存力的充足性可以衡量一个国家的数据存力是否足够充足以支撑其经济社会高质量的发展需求。

全球范围内,每万亿美元GDP汇聚的数据量均保持14.5%的快速增长态势,北美的美国、加拿大等发达国家更是达到16.8%,反映出数据量增长的迅猛之势。

存力投资增长率指标使用2017年-2019年三年间各国的存储投资的年复合增长率来衡量各国增长动能。高增长率体现的是在各国已有的数据存储规模之上数据存储的发展速度和潜力。

沙特、中国、俄罗斯等发展中国家的存储市场增长迅速2017-2019年复合存力投资增长率均超过40%。

存力作为算力的重要组成部分,随着大模型对算力需求的爆发式增长,行业对存储能力提出了更高的需求,先进存力也成为了算力高质量发展的重要发展方向。

02

AI时代,存力如何演进?

AI时代对于存储提出了更多的要求:

高速数据处理:尤其是深度学习模型,AI需要快速处理和分析庞大数据集,这要求存储系统必须具备高效的数据读写能力。

大容量存储:随着数据量的剧增,存储系统需要更大的空间来容纳训练数据、模型参数及推理结果。

低延迟访问:实时AI应用对存储系统的响应速度要求极高,低延迟的存储解决方案能显著提高处理速度和应用响应时间。

可扩展性:存储系统必须能够随着AI应用的扩展而灵活增长,适应日益增长的存储需求。

按照调取速度的快慢和成本的高低,AI时代需要的内存和存储器可以分为四种。

最末的层级,处于金字塔的低端,对应的是速度较慢的、成本较低的SSD存储产品。

SSD属于数据存储的底座,相较于DRAM解决的主要是计算时数据传输的问题,巨量数据保存还是依靠NAND Flash制成的SSD、嵌入式存储。

“SSD将成为AI的一部分。”花旗分析师Peter Lee日前发布报告,提醒投资者注意即将到来的“更换周期”,SSD可能会取代硬盘驱动器用于AI。他指出,SSD“更适合AI训练应用”,因为其速度较HDD快40倍。

SSD的演进主要通过两方面:一方面是容量,另一方面是性能和功耗。

一方面,AI时代对于高容量的SSD需求正在快速上升。需要SSD不仅有更大的存储容量,还要能够在不牺牲性能的前提下,通过技术的改进等提高NAND密度。

随着 TLC 闪存架构开始达到原始存储容量的极限,QLC 代表了希望不断突破主流消费 SSD 容量极限的 SSD 制造商的未来。目前,存储厂商都已经发布QLC闪存。

三星发布的新一代 QLC NAND 闪存,其面积密度极高,达到每平方毫米 28.5 Gbit。SK海力士的子公司,Solidigm推出了采用QLC闪存的61.44 TB D5-P5336 SSD产品。

从最新的需求来看,TrendForce集邦咨询表示,第二季AI服务器对大容量SSD的需求持续看涨,除了推升第二季Enterprise SSD合约价格续涨超过两成,预估第二季Enterprise SSD营收成长幅度仍有机会续增20%,QLC大容量产品的需求动能明显优于其他容量。

另一方面,在性能和功耗方面,随着数据中心对于存储设备速度要求的不断提升,SSD需要提供更高的IOPS和带宽(GBPS),同时在保证高性能的同时必须有效控制功率消耗,实现单位性能所需的能耗降低。

协议接口和NAND接口速率是*助力点。目前,为了追求高性能,NVMe/PCIe SSD是数据中心的高性能标配。

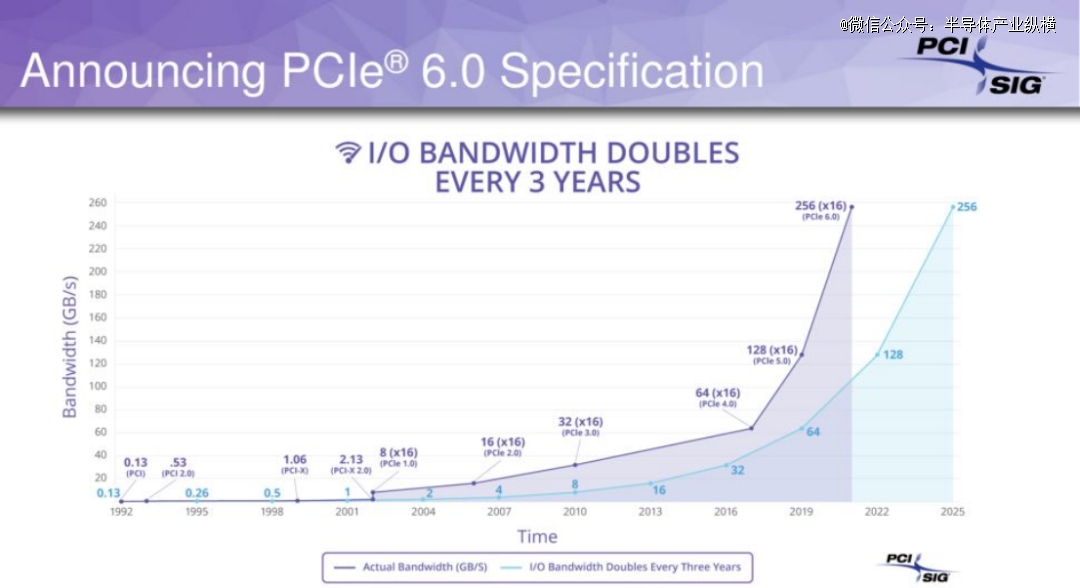

PCIe5.0的规范早在5年前就已经发布,不过散热、信号损耗等问题一直是阻止PCIe5.0 SSD在PC市场推广的重要原因。不过,随着技术的普及,PCIe5.0的市场份额将不断扩大。三星半导体也预计,PCIe5.0很快会应用于PC端的SSD产品。

此外,目前PCIe 6.0已经发布,将把数据传输速率从PCIe 5.0的32 GT/s和PCIe 4.0的16 GT/s提高到每引脚64 GT/s,PCIe 6.0 ×16通道单向理论数据传输速度达到了128 GB/s。

第三层级,则是可以以更高性价比给大模型提供跟大容量的CXL的内存扩展方案。

需要注意的是,PCLe是可扩展且有层次的,带有嵌入式交换机或交换机芯片,支持一个根端口与多个终端连接,例如多个存储设备。然而,这种实现方式在一种带有孤立内存池的大型系统中存在局限,这种系统中的处理器和加速器在同一个 64 位地址空间内共享相同的数据和内存空间进行异构计算。

与使用 CXL 的替代实现方案相比,缺乏缓存一致性机制会导致这些应用的内存性能低下,延迟不可接受。

因此,虽然 64GT/s 的 PCIe 6.0.1 的引入有助于增加存储应用程序的可用带宽,而延迟增加很少或没有增加,但一致性的缺乏仍然限制了 PCIe 应用程序,如传统的 SSD 这种块存储设备。对于这些存储应用,使用 PCIe 作为传输接口的 NVMe 已经占据了 SSD 技术的主导地位。正在开发中的下一代 SSD,它们将使用 CXL 接口替代 PCIe。

从产品来看,三星有两款CXL存储模组用在数据存储方面。一款是已经推出的*代基于SoC的CXL2.0产品CMM-D,三星半导体计划在2025年发布搭载第二代控制器、容量为128GB的新产品。与此同时,三星还在不断研发同时使用NAND和DRAM的混合式CXL存储模组架构CMM-H,该架构针对AI和ML系统使用。

美光推出了CZ120 CXL内存扩展方案,最多可以扩展2TB内存容量。此外,添加可扩展内存后,Llama2 LLM的推理性能提升了22%,可以更大程度释放GPU性能。

第二层级,是速度更快,价格也更高的DDR内存。

DDR、LPDDR、GDDR是基于DRAM的三种内存规范或标准。DDR因其性能和成本优势成为目前PC和服务器端主流内存。

2020年,为解决从客户端系统到高性能服务器的广泛应用所面临的性能和功耗挑战,JEDEC正式发布了下一代主流内存标准DDR5 SDRAM的最终规范(JESD79-5)。

JEDEC将DDR5描述为一种“具备革命意义”的内存架构。

与DDR4相比,DDR5具备更高速度、更大容量和更低能耗等特点。DDR5内存的最高传输速率达6.4Gbps,比DDR4高出一倍。如今,无论是 PC、笔记本电脑还是人工智能,各行业正在加速向 DDR5 新纪元迈进。

2024年年初DDR5供不应求,缺口达3%。据市场消息人士预测,得益于生成式人工智能的需求,DDR5在内存市场的渗透率将加速增加,预计将在2024年下半年达到两位数百分比。

目前在AI服务器中的另一个趋势则是DDR转向GDDR。

DDR存储器的设计延迟极低,它的目的是尽可能快地传输少量缓存数据,来配合CPU进行串行计算。而显卡多为并行任务,有大量重复存取需求,但它对于延时的要求没有CPU那么高。于是,具有更大带宽和更高频率的GDDR出现了。

今天GDDR的标准更新到了第七代,也就是GDDR7。美光已经宣布了将用于显示卡的新一代GDDR7显示存储器开始送样测试,相比前一代GDDR6显示存储器将可提升60%资料传输频宽,同时也新增睡眠模式,将使待机能耗降低70%。

*个层级处于金字塔顶端,对应工作速度非常快,但是成本非常昂贵的内存,比如HBM。作为内存芯片,它可以将大量数据快速喂养给GPU。

HBM是高带宽存储器,是基于3D堆栈工艺的高性能DRAM,其实就是将很多个DDR芯片堆叠在一起后和GPU封装在一起,实现大容量,高位宽的DDR组合阵列。

HBM 解决了传统 GDDR 遇到的“内存墙”问题,采用了近存计算架构,不通过外部连线的方式与 GPU/CPU/Soc 连接,而是通过中间介质层紧凑快速地连接信号处理器芯片,极大的节省了数据传输所使用的时间与耗能。

HBM的技术方面已经发展至第五代。分别是:HBM、HBM2(第二代)、HBM2E(第三代)、HBM3(第四代)、HBM3E(第五代)。对于规格更高的HBM4,可能在2026年推出。

HBM的市场方面,在2023年的全球HBM市场,SK海力士市占率有望提升至53%,三星市占率为38%、美光市占率约为9%。不过,5日美光宣布预计2024会计年度将抢下HBM市场超过20%的份额。AMD 和 NVIDIA 两家尖端的 GPU都陆续配备了 HBM。

03

存储的下一站:存算一体

到这里,我们已经能看到存力不断演进的过程。

从一开始的数据存储SSD,再到数据计算DDR5,再到进一步解决数据传输问题的HBM,存储一直在解决数据存取的效率问题。因此,存储的下一步,关键还是在打破“存储墙”。

存算一体的优势正是解决传统冯·诺依曼架构下的“存储墙”和“功耗墙”问题。消除不必要的数据搬移延迟和功耗,并使用存储单元提升算力,成百上千倍的提高计算效率,降低成本。

AMD、特斯拉、三星、阿里巴巴等公司都曾在公开场合表示,下一代技术的储备和演进的方向是在“存算一体”技术架构中寻找新的发展动能。

例如,阿里达摩院就曾表示,相比传统CPU计算系统,存算一体芯片的性能可以提升10倍以上,能效提升超过300倍。

目前,存算一体的技术路径大致分为近存计算、存内处理(PIM)、存内计算(CIM)。国际巨头比如英特尔、IBM、特斯拉、三星、阿里等,探索磁性存储器(MRAM)、忆阻器(RRAM)等产品相继量产;国内方面知存科技、亿铸科技、九天睿芯等初创公司都在押注PIM、CIM等“存”与“算”更亲密的存算一体技术路线。

免责声明:该文章系本站转载,旨在为读者提供更多信息资讯。所涉内容不构成投资、消费建议,仅供读者参考。